大模型——如何本地跑通一个大模型

如何本地跑通一个大模型

前言

这里主要借助两个开源项目 ollama 和 openwebui 这两个项目,来尝试本地跑通llama3.1 8b 、 mistral-nemo 12b 和 qwen2 7b 这些模型,再大的模型机器也撑不住了,机器配置如下:

CPU: M2 Max

内存:32 GB

内容

ollama:https://ollama.com/

ollama GitHub:https://github.com/ollama/ollama

ollama Models:https://ollama.com/library

openwebui:https://openwebui.com/

openwebui GitHub:https://github.com/open-webui/open-webui

安装ollama

访问 ollama 网站,根据自身的平台来下载应用,下载后正常安装即可,安装完成后运行命令来拉取模型,模型可访问 ollama Models 选择相应的模型后,会有对应的命令,终端执行即可。

## llama3.1

$ ollama run llama3.1:8b

## qwen2.5

$ ollama run qwen2.5:7b

## mistral-nemo

$ ollama run mistral-nemo:12b安装openwebui

因为我的 ollama 是在本地的,所以我这里直接基于 docker 来运行 openwebui,运行命令如下:

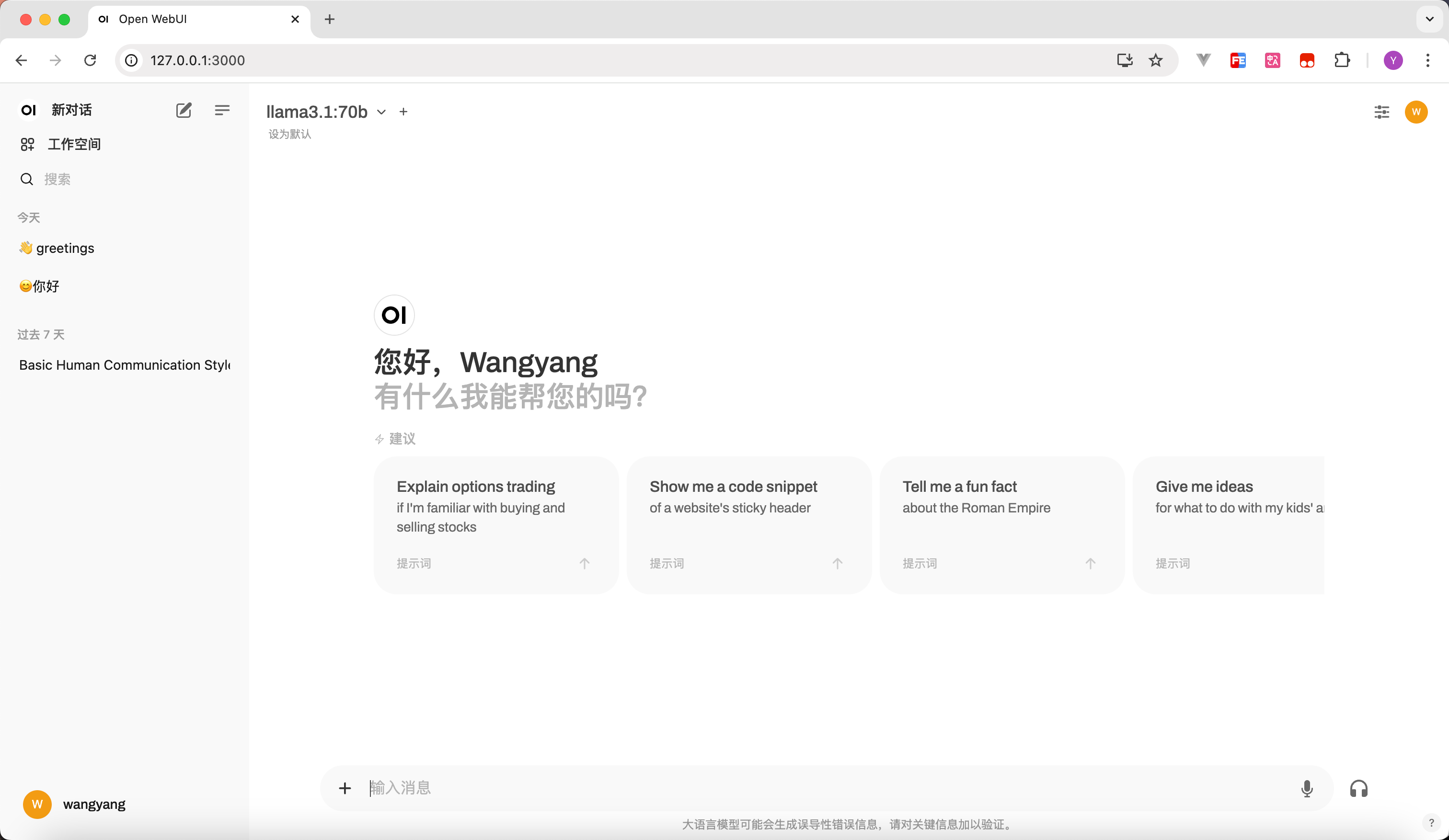

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main运行成功后,我们访问 127.0.0.1:3000 即可打开本地的聊窗口,创建好对应的账号登录后,访问界面如下:

总结

总的来说,现在基于开源的项目,我们能够很快的搭建一个自己本地使用的模型,当前如果你不存在数据安全的问题,使用国内或国外的最新的大模型体验肯定更好。

尝试跑了下llama3.1 70b的模型,跑起来后内存直线飙升,32GB内存的机器不建议尝试跑70b